La computadora es de los inventos más importantes en la historia de la humanidad. La continua necesidad de innovar en productos y máquinas permitió el desarrollo de diferentes tipos hasta llegar a los que se tienen en la actualidad. Asimismo, existen otras denominadas supercomputadoras, cuya capacidad de cálculo implica un menor consumo de recursos

Danahé San Juan / Fotografías: Rubén Darío Betancourt

El cerebro humano es un procesador de datos que va recabando la información recogida por los sentidos, gracias a que posee 100,000 millones de neuronas, aproximadamente. A pesar de esto, su capacidad no se puede equiparar a la de un ordenador; sin embargo, desde hace mucho el imaginario de la ciencia ficción desarrolló tecnologías nunca antes vistas. Tal es el caso del escritor H.G. Wells, quien en un libro que reúne escritos y discursos bajo el título World Brain, expuso su visión de un cerebro mundial o una especie de enciclopedia universal que funcione como un órgano social para ayudar al ser humano a resolver problemas de cualquier índole, al tiempo que atrae toda la riqueza mental dispersa del mundo en un entendimiento común. De cierta forma, las supercomputadoras funcionan de una manera similar: reúnen información y la analizan con ayuda de lenguajes computacionales para ayudar a los científicos a desarrollar sus investigaciones empleando un menor número de recursos, que a su vez se traduce en ahorro económico. Es por esto que el universo del supercómputo se ha convertido en una de las herramientas indispensables para llevar a cabo investigaciones y proyectos para diversas áreas de la investigación, que van desde la realización de complejos cálculos aplicados, sobre todo en la ciencia, pero también de utilidad para la mecánica, simulación de modelos climáticos, cuántica, creación de combustibles, resolución de problemas astronómicos, físicos y de ingeniería química.

Fabián Romo, director de Sistemas y Servicios Institucionales de la Dirección General de Cómputo y Tecnologías de la Información y Comunicación de la UNAM (Dgetic), precisa que una supercomputadora es un “equipo de muy alto rendimiento. Sus características físicas y funcionales tienen una gran capacidad de almacenamiento de la información y sus componentes funcionan a una alta velocidad de comunicación. También cuenta con elementos de prestación con gran cantidad de almacenamiento en memoria RAM”. Esta capacidad se alcanza por medio de un sistema en clúster, es decir, racimos de computadoras que se comportan como una sola y, por tanto, comparten la memoria. Esto significa que la capacidad de almacenamiento se distribuye, por lo que el funcionamiento se lleva a cabo mediante “colas de trabajos”, a diferencia de una red común que desata peticiones puntuales. Otra de sus características consiste en el procesamiento de números, a diferencia de los equipos comunes que procesan texto, computo gráfico, edición de audio y vídeo. De igual forma, una supercomputadora opera con modelos matemáticos y lenguajes de alta codificación lógica, como Fortran o el lenguaje C.

Supercomputadora en territorio Puma

La Universidad Nacional Autónoma de México (UNAM) es una entidad académica que se destaca por haber instalado la primera computadora de grandes dimensiones en México. El equipo se localizó en el Centro de Cálculo Electrónico (CCE), ubicado en la antigua Facultad de Ciencias. Este sistema (IBM-650 de bulbos) se le rentó a la multinacional International Business Machines (IBM), en 1958. Según el Centro de Investigación y de Estudios Avanzados del Instituto Politécnico Nacional (Cinvestav), “operaba con un tambor magnético con capacidad para 20,000 dígitos, efectuaba 1,300 operaciones de suma y resta por segundo y funcionaba con lectora y perforadora de tarjetas, adoptando un sistema numérico llamado bi-quinario”.

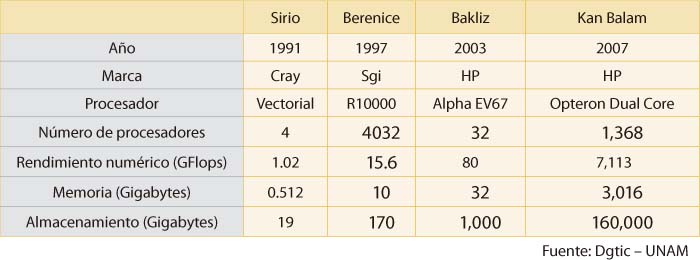

La primera supercomputadora fue instalada en 1991: la CRAY Y/MP. Este equipo era de muy altas prestaciones y rendimiento. Fue la primera de su tipo en América Latina; poseía cuatro procesadores, un rendimiento de 1.02 GFlops, una memoria de 0.512 GB y un almacenamiento de 19 GB. A partir de entonces la UNAM ha instalado cinco generaciones de supercomputadoras.

El felino mayor

El felino mayor

Esta supercomputadora, cuyo nombre proviene del náhuatl y significa gato, felino mayor o puma, comenzó a dar servicio en enero de 2013, pero el mes pasado se dio a conocer que su capacidad se amplió para apoyar a la investigación, de tal forma que ahora tiene 228 teraflops de rendimiento teórico, lo cual equivale a 86 mil 365 computadoras personales de última generación. Cuenta con 8, 344 procesadores, casi 45 terabytes de memoria, una red InfiniBand y 750 terabytes de almacenamiento.

Fabián Romo afirma que Miztli fue la más grande en una institución de educación superior e investigación en toda Latinoamérica de 2013 a 2016. Actualmente ocupa el segundo lugar de México y se encuentra entre las primeras cinco en América Latina. Gracias a la ampliación, ahora ofrece una reserva de 70 millones de horas CPU al año, de los cuales 10 por ciento está reservado para investigadores de instituciones colaboradoras que requieran del equipo y no lo tengan disponible.

Frío y energía

Miztli cuenta con un sistema de refrigeración de sala (CRAC) que consiste en equipos de regulación eléctrica y aire acondicionado instalados en la sala de centro de datos y supercómputo. Esto permite tener una temperatura máxima de entre 13 y 15 grados centígrados, con una humedad no superior al 70 por ciento, sin condensación, para que todos los equipos operen de manera correcta. “El sistema es de precisión y expansión directa y cuenta con un equipo de manejadora y condensadora con gas refrigerante R22”, comenta el ingeniero Bernardo Galeana, jefe del Departamento de Infraestructura Electromecánica dela Dirección de Telecomunicaciones de la UNAM.

La supercomputadora está supervisada permanentemente por el equipo de electromecánica, de tal forma que aproximadamente seis veces al día se realizan revisiones para verificar el estado de los sistemas de aire acondicionado y de abastecimiento electromecánico. La ventilación se maneja en un cuarto cerrado, de donde la condensadora expulsa el aire caliente para enfriar el lugar.

Energéticamente es alimentada por dos brazos eléctricos que le permiten ofrecer una óptima función operativa. La Dgetic tiene una acometida generada por dos brazos y dos generadores de energía eléctrica independientes, señala el ingeniero Galeana. “Cada brazo tiene dos equipos de energía interrumpida con capacidad de 160 cargas, además de 320 cargas instaladas por brazo, es decir, 640 cargas en total”.

Asimismo, el equipo está respaldado por dos sistemas de alimentación ininterrumpida (UPS, por sus siglas en inglés) que garantizan su continua operación. Esto, a su vez, se combina con el monitoreo de los sensores llevado a cabo por la Coordinación de Supercómputo de la UNAM, la cual constantemente realiza mantenimientos parciales-preventivos, además de los preventivos-correctivos 7/24 los 365 días del año, y las revisiones mensuales de todos los subsistemas que componen el sistema de enfriamiento. Del mantenimiento electromecánico se encargan 24 personas distribuidas en tres turnos. En cuanto al del supercómputo, 15 personas en tres turnos de 7/24.

Un aspecto importante es la automatización de los sensores que mejoró el monitoreo de la vitalidad del equipo, ya que el sistema emite alertas telefónicas y correos electrónicos para dar informes sobre el funcionamiento de la supercomputadora. Los equipos cuentan con sensores de precisión que activan el sistema de humidificación y deshumidificación. Cuando perciben que la humedad rebasa los límites programados, activan unas lámparas que condensan el aire y humedecen el ambiente; mientras que al llegar a la humedad programada, las apagan. Por su parte, la iluminación se realiza con lámparas fluorescentes controladas por interruptores.

En cuanto a estrategias de eficiencia energética para reducir el consumo de energía, los especialistas ajustan los parámetros de temperatura, de tal forma que en temporadas frías se sube la temperatura un grado y en temporadas de calor se disminuye la misma cantidad paulatinamente hasta llegar a los 22 grados centígrados. Con estas acciones se logran ahorros aproximados de 10 por ciento en el consumo energético.

Bernardo Galeana detalla que “se ha pensado en la utilización de fuentes sustentables de producción de energía que abastezcan a la supercomputadora, pero primero tenemos que estabilizar todo el sistema eléctrico, optimizarlo y luego conectarle el sistema sustentable. Los equipos de refrigeración son equipos de hace 14 años y funcionan con corriente alterna, los sistemas actuales son de corriente directa, más eficientes. Por tanto, primero hay que optimizar nuestros equipos y ya después pensar en la fuente de energía renovable”.

Seguridad

Las instalaciones de la Dgetic se encuentran ubicadas en pedregal volcánico, por lo que el edificio es capaz de resistir sismos de hasta nueve grados Richter. Además, el cuarto que alberga a la supercomputadora y la base de datos es “una especie de carcasa reforzada con concreto y columnas de metal. Tenemos sensores de humo para incendios y todos los sensores de sistemas de acceso en el Centro de Ciencias de la Complejidad (C3), con poco más de 20 cámaras de monitoreo. En cuanto a inundaciones es muy complejo porque estamos en una zona alta y de escaso flujo pluvial, lo cierto es que poseemos un plan de contingencia por inundación con bombas para drenaje”, recalca el especialista. En caso de que se registrara una descarga eléctrica contamos con un sistema de pararrayos, jaula de Faraday y supresores de transitorios (unidades con un equipo electrónico para regular los picos de voltaje y corriente) desde la comitiva principal hasta la entrada de equipos de energía interrumpida.

Impacto social y medioambiental

Un equipo de estas dimensiones, de enorme utilidad para diversos campos de la ciencia, es uno de los recursos más importantes que puedan existir para la investigación. Su impacto, aunque difícil de visualizar, se encuentra en cada detalle de la vida cotidiana, por ejemplo, “los beneficios obtenidos en un teléfono móvil son resultado de la investigación y cálculos de supercómputo. La medicina preventiva o la genómica es otro caso de éxito de un superordenador, las cuales tienen aplicaciones de supercómputo, ya que utilizan variables muy específicas para predecir enfermedades hereditarias y las probabilidades de su desarrollo en una persona. En cuestión de modelos automotrices, todas sus variables se visualizan antes de construir los modelos experimentales que llevan maniquíes y se estrellan en muros. Modelos matemáticos econométricos que generan información del comportamiento del mercado, hasta información popular como otro dígito fraccionario de PI, predicción de eclipses o un agujero negro”, indica el ingeniero Romo.

En la actualidad, es muy difícil que un equipo de alto rendimiento sea cien por ciento verde, debido a que se requiere una instalación sustentable muy grande para abastecerlo de energía. Con el paso del tiempo, las nuevas generaciones de supercomputadoras de la UNAM tienen cada vez mejor comunicación, capacidad de memoria, procesadores centrales más rápidos, etcétera; y se prevé que habrá operadores cuánticos u operadores ópticos que reducirán aún más el consumo eléctrico, como parte de los proyectos de la UNAM de reducir la huella de carbono.