La historia de la tecnología de aire acondicionado de precisión comienza a principios de los 70 con la climatización de un sinnúmero de salas de servidores. Con la transición al centro de datos moderno, el paisaje diverso de soluciones HVAC de precisión que conocemos y en las que confiamos hoy en día gradualmente empezó a nacer

Noé Ponce Meraz

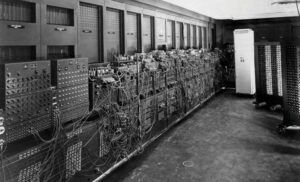

Cuando en 1965 se presentó el primer equipo de aire acondicionado (AA), la tecnología de precisión, tal como la conocemos hoy en día, era todavía inconcebible. También fue un sistema de confort que enfriaba las habitaciones, mientras proporcionaba deshumidificación (no deseada), pues no estaba diseñado para climatizar salas informáticas. Básicamente no había aún un mercado para este tipo de soluciones a mediados de los 60. Esto sucedió cuando la compañía IBM lanzó su sistema de unidades centrales conocido como Mainframe 370, en 1970. A pesar de su elevado precio de compra de 4.6 millones de dólares, éste evolucionó para convertirse en el mainframe de mayor éxito y revolucionó el uso de las Tecnologías de la Información (TI). Por primera vez, los centros de cómputo fueron creados en gran escala, a pesar de que todavía no eran conocidos como data centers. Una excepción fue el Deutsche Rechenzentrum en Darmstadt, fundado en 1961 y que empleó la palabra alemana para “centro de datos” en su título.

En un principio estas salas no eran nada parecidas a las actuales. Fotografías antiguas muestran que a menudo eran oficinas donde las mainframes eran colocadas al lado de escritorios, máquinas de escribir, impresoras, unidades de disco extraíbles y otros dispositivos eléctricos. Esto puede haber tenido su propio encanto, pero proporcionar el AA necesario pronto se convirtió en un reto, es decir, para satisfacer por igual las exigencias de los equipos y trabajadores.

El origen del aire acondicionado de precisión se debió a la necesidad de crear un clima agradable para las personas en la habitación, pero que además asegurara que cada unidad funcionara a plena capacidad. Por tanto, el equipo instalado tenía que ser capaz de lograr una temperatura ambiente de 21 °C (+/- 1 °C) y un nivel de humedad de 50 por ciento, aproximadamente. Esto sólo fue posible con los sistemas desarrollados específicamente para salas de cómputo, los cuales fueron a menudo alojados en gabinetes con paneles a prueba de ruido, con el fin de evitar las perturbaciones por el ruido de los equipos.

Los centros de datos como ahora los conocemos se crearon cuando los espacios de oficinas y salas de equipos fueron separados en las décadas de los 80 y 90. A partir de eso surgieron muchas de las soluciones comunes que se utilizan en la actualidad, tales como los sistemas de AA con pisos elevados o unidades enfriadoras secundarias instaladas justo al lado de los racks de servidores.

A inicios de los 80, los siguientes pasos sucedieron rápidamente: la tendencia hacia una mayor protección del medioambiente y del clima colocó firmemente, por primera vez, el uso de energía en el primer plano. El resultado fue la creación del sistema de ahorro de energía con Free Cooling Indirecto, el cual se convirtió en un éxito internacional, debido a que era un sistema de control con microprocesador programable libremente, que supervisaba todos los componentes de un AA, así como las condiciones en el piso elevado. Por consiguiente, el nuevo módulo de control hizo posible el modo de carga parcial eficiente y simplificó la planificación de configuraciones redundantes. Luego, en la década de los 90, la mayoría de las unidades de AA de precisión instaladas en Alemania ya estaban equipadas con este nuevo sistema.

En otros aspectos, los sistemas también comenzaron a parecerse cada vez más a los de ahora, ofreciendo unidades de ventiladores controlables, serpentines ahorradores de energía y calentamiento de refrigerante, entre otras características. Los rápidos avances técnicos siguieron a la perfección en los 90. La fuerza impulsora detrás de esto fue el creciente número de centros de datos y la expansión de la red de telefonía celular, lo que provocó el aumento de la demanda de AA de precisión para las estaciones base de telefonía móvil. Para abastecer estas necesidades se buscó mejorar continuamente la gama de tecnología y se realizó el lanzamiento de los compresores scroll, entre otros productos.

Desde mediados de los 90 se hizo evidente que sólo se conseguirían más avances, si se transitaba hacia un camino totalmente nuevo. En consecuencia, alrededor de 1995, se invirtió tiempo y recursos en investigación básica, para actualizar los componentes de los sistemas convencionales. El objetivo era desarrollar el AA de precisión perfecto: un sistema que brindara el máximo beneficio para los clientes y el medioambiente. Eso significaba un equipo con la menor huella de carbono, a través de la mayor eficiencia energética posible. Todo esto sin poner en riesgo la disponibilidad. Pero no fue si no hasta 2003 que se presentó el primer AA de precisión equipado con ventiladores EC de alta eficiencia como estándar.

Prescindir del refrigerante, el tema más importante del futuro

En el futuro, los fabricantes de AA de precisión tendrán que hacer frente a la cuestión de los refrigerantes químicos. La normativa legal es cada vez más estricta, impulsando a buscar soluciones alternativas y/o a la medida, otro de los temas clave para el porvenir. Aun y cuando los data centers y salas de servidores apenas se diferencian unos de otros, los requisitos que enfrenta el AA son cada vez más individualizados y la tendencia es definitivamente alejarse de las soluciones estandarizadas.

Los directivos de Yahoo, LinkedIn y Groupon coinciden en señalar a la eficiencia energética, la nube y la automatización como los grandes retos para construir los data centers de la futura economía digital.

Aunque no seamos conscientes en nuestro día a día, detrás de todos los servicios en línea que usamos existen lugares sumamente complejos donde se recopila, almacena y procesa toda esa ingente cantidad de información. Unos edificios en donde miles de servidores se apilan en futuristas salas y los cables de red conviven en una extraña simbiosis con tuberías de agua y ventiladores industriales para refrigerar los equipos.

Paralelo al crecimiento de la sociedad de la información, estos centros de datos han evolucionado para enfrentar las nuevas demandas, con una importante consolidación en el sector, la integración de soluciones automatizadas para su gestión o la llegada de tecnologías como la virtualización, la nube o la informática, entendida como contenedores.

En virtud de lo anterior, aunado a la mejora de la potencia de los servidores, hoy los data centers tienen poco que ver con los de hace 10 años. El rendimiento de unas instalaciones de 3 mil metros cuadrados hace una década puede concentrarse hoy en un solo rack e, incluso, en un único servidor. Asimismo, la irrupción de sistemas de refrigeración con menor consumo energético –como la refrigeración por inmersión– ayudan a reducir la huella medioambiental provocadas por la industria digital.

Yuval Bachar, responsable de Global Infraestructure Architecture en LinkedIn, cree que estamos asistiendo a una “evolución hacia centros de datos centralizados debido a la nube, en la que los proveedores necesitan optimizarse más en términos de densidad y energía”. El directivo también menciona que el otro gran reto de los centros de datos de tercera generación es el personal humano. “Hace 10 años, 10 mil servidores eran mantenidos por un equipo muy grande de personas, ahora tenemos 250 mil servidores en una misma localización, consolidados de forma que parezcan una sola gran máquina, controlados por apenas decenas de trabajadores. En un futuro veremos data centers a oscuras, sin personas, con infraestructuras capaces de autoarreglarse en caso de incidencia”, explica Bachar.

Refrigeración líquida y desaparición de pasillos fríos, ¿nuevo escenario para los CPD?

Las tendencias de refrigeración en estos lugares las marcan, en gran medida, los fabricantes de TI. Hemos visto cómo las infraestructuras físicas, concretamente las de climatización, siempre se han adaptado al diseño, la configuración y los tipos de servidores fabricados en cada momento.

Ahora, la tendencia es volver a refrigerar como en los 70. En esa década las supercomputadoras eran tan grandes y con tal carga térmica que la única forma eficiente de refrigerarlos era mediante serpentín de agua fría en el interior del ordenador. En estos casos se instalaban los data chiller, es decir, enfriadoras de agua que se conectaban directamente a los equipos. Todo un clásico que vuelve a versionarse como una nueva tendencia bajo la denominación de refrigeración líquida.

Más eficiencia energética

La refrigeración líquida o por inmersión es un modo de mejorar, significativamente, la eficiencia de la eliminación de calor en un centro de datos. Se puede refrigerar con agua o con líquidos equivalentes que tengan mayor poder calorífico o, que en caso de fuga, evaporen. Por ende, es posible enfriar con refrigerantes líquidos.

Ahora hay más alternativas que en los 70 del siglo pasado, pero el concepto subyacente no ha variado tanto. Sin embargo, para que esta tendencia se imponga en el mercado es necesario que comiencen a suministrarse equipos capaces de refrigerar mediante líquidos para que éstos lleguen directamente al chip, en lugar del calor de la sala. Un modo de mejorar significativamente la eficiencia durante el proceso de eliminación de calor.

Desaparición de los pasillos fríos

Éstos han sido una de las técnicas de mejora en la climatización de los centros de datos más utilizadas en los últimos años. Básicamente, con estas instalaciones se consigue reducir el PUE, además de ahorros en el consumo eléctrico del sistema.

No obstante, para servidores de alta densidad la tendencia va encaminada a la desaparición de pasillos fríos, abriéndose paso en su lugar soluciones de eliminación de calor directamente en el rack, servidor o chip en data centers templados.

Noé Ponce Meraz

Es maestro en Ingeniería Eléctrica por la UANL (México), cuenta con las certificaciones CCRE-MX-077 del ICREA, diplomados de negocios en Tecnológico de Monterrey, así como cursos en el extranjero. Es parte de los proyectos de Ingeniería de equipos de climatización para data center.